Apple 似乎已经放弃了自 Butterfly Keyboard 以来最不受欢迎的创新,在对该想法的广泛批评之后,从其网站上偷偷地删除了对其有争议的 CSAM 扫描/监视技术的提及。

儿童保护工具

该公司在 8 月宣布计划在 iPhone 上推出“监控即服务”。

当时,它揭示了 iOS 15.2 和另一个工具中现在可用的新通信安全功能——包括根据一组数据扫描用户设备以识别儿童性虐待材料 (CSAM) 的能力。 如果发现此类材料,系统会标记该用户进行调查。

[通过 Computerworld 的时事通讯了解最新的 IT 思想领导力、见解、操作方法和分析。 ]

反应是立即的。 全球的隐私权倡导者很快意识到,如果您的 iPhone 可以扫描您的系统进行某项操作,那么很容易就会被要求扫描另一项操作。 他们警告说,这种技术将成为潘多拉魔盒,容易被专制政府滥用。 研究人员还警告说,该技术可能不会特别有效,并且可能会被滥用或操纵以牵连无辜的人。

Apple 尝试了一次魅力攻势,但失败了。 虽然一些行业观察家试图在互联网上发生的一切都可以被追踪的基础上使该计划正常化,但大多数人仍然完全不相信。

人们达成共识,通过引入这样一个系统,Apple 有意或无意地开创了一个设备上通用无保证监控的新时代,这与它的隐私承诺相去甚远。

塔夫茨大学网络安全和政策教授苏珊兰道说:“这非常危险。 这对商业、国家安全、公共安全和隐私都是危险的。”

[‘IT 有一个新的’It Crowd’:加入 CIO Tech Talk 社区]

虽然所有批评者都认为 CSAM 是一种邪恶,但事实证明,人们对此类工具被滥用于更广泛人群的恐惧难以转移。

9 月,Apple 推迟了该计划,称:“根据客户、倡导团体、研究人员和其他人的反馈,我们决定在未来几个月内花更多时间收集意见并做出改进,然后再发布这些至关重要的儿童安全功能。 ”

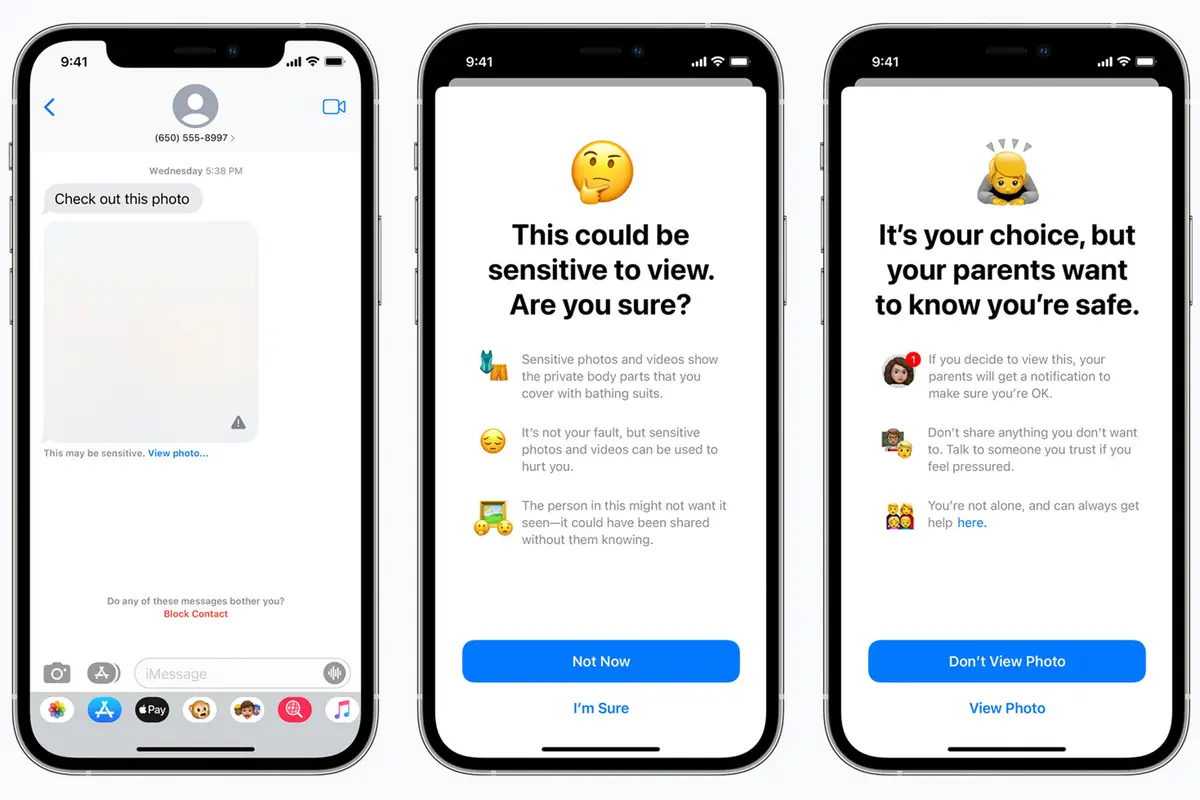

MacRumors 声称所有提及 CSAM 扫描的内容现已从 Apple 的儿童安全页面中删除,该页面现在讨论了消息和搜索保护中的通信安全工具。 这些工具使用设备上的机器学习来识别色情图像并阻止此类材料。 如果他们搜索此类信息,他们还会为孩子们提供建议。 这个工具有一个变化:如果他们的孩子选择查看此类项目,它不再提醒父母,部分原因是批评者指出这可能会给一些孩子带来风险。

Apple 试图保护儿童免受此类材料的侵害是件好事,但它似乎放弃了该组件也是件好事,至少目前是这样。

我不认为公司已经完全放弃了这个想法。 如果它没有完全致力于寻找保护儿童免受此类材料侵害的方法,它就不会走到这一步。 我想它现在寻求的是一个提供有效保护但不能被滥用以伤害无辜者或被专制政权扩张的系统。

危险在于,虽然苹果一开始就发明了这种技术,但它仍可能会面临一些政府压力,要求其使用它。

在短期内,它已经扫描存储在 iCloud 中的图像以查找此类材料,这与业内其他公司已经在做的事情非常相似。

当然,考虑到最近的 NSO Group 攻击、高调的安全恐慌、社交媒体上内容驱动的“部落”的武器化和分裂化以及困扰数字业务的勒索软件攻击海啸,人们很容易认为技术创新已经达到了一个新的高度。 意想不到的和深刻的负面后果的顶峰。 或许我们现在应该探索技术现在在多大程度上破坏了 HomeBrew 计算机俱乐部的极客们最初寻求培养和保护的基本自由?