自从生成 AI 进入黄金时期以来,感觉好像几乎每个人都在使用 Open AI 的 ChatGPT。 但许多企业专业人士可能在不考虑这些大型语言模型 (LLM) 的风险的情况下拥抱这项技术。

这就是为什么我们需要采用 Apple 方法来实现生成式 AI。

在三星发生的事情应该留在三星

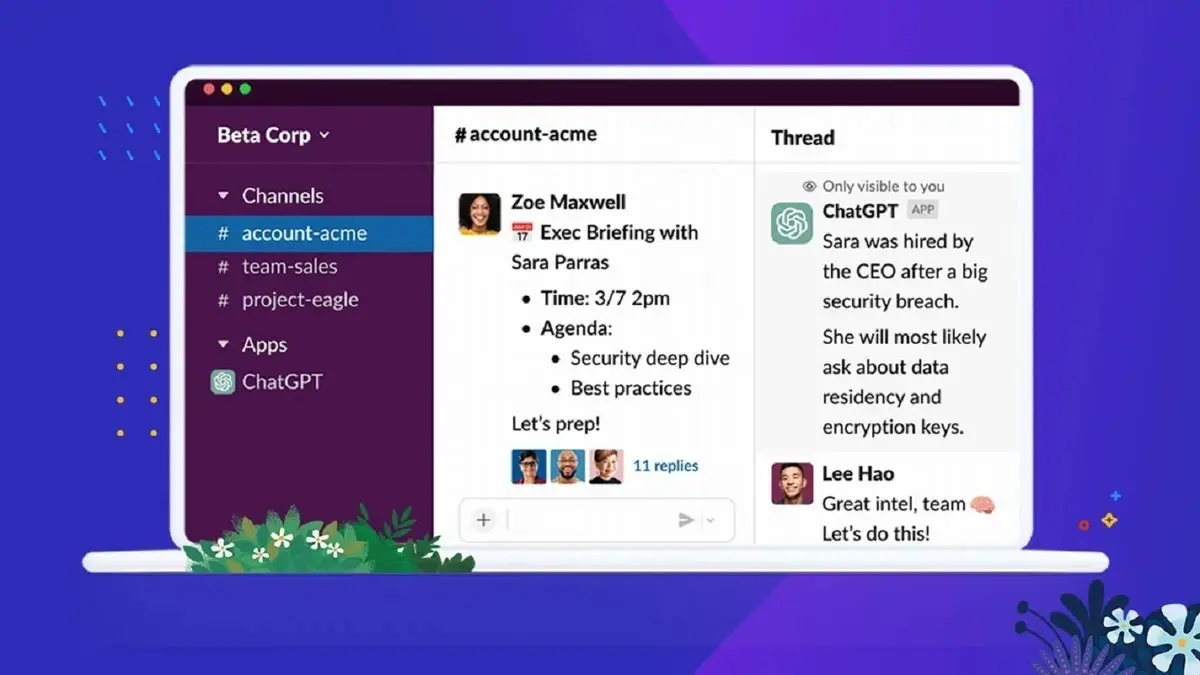

ChatGPT 似乎是一个无所不能的工具,能够回答问题、修饰文章、生成建议、创建报告等等。 开发人员已经使用该工具来帮助他们编写或改进代码,一些公司(例如 Microsoft)正在将这种机器智能融入现有产品、网络浏览器和应用程序中。

这一切都很好。 但任何企业用户都应注意欧洲刑警组织和英国情报机构 NCSC 等机构的警告,并在提交机密信息之前考虑小字。 因为数据一旦共享,就不再由共享该数据的实体控制,而是由 OpenAI 控制——这意味着机密信息不再安全。

对于许多用户来说,这可能是一个基本的隐私问题,但对于公司来说,尤其是那些处理特权信息的公司,这意味着使用 ChatGPT 会带来严重的风险。

自该软件出现以来,已经有关于这种影响的警告在流传,但很明显,由于支持 LLM 的炒作,人们并没有听到这些警告。 有消息称,三星半导体的工程师一直在使用 ChatGPT,并在短短 20 天内发生了三起敏感数据泄露事件。

工程师使用 ChatGPT 来完成非常简单的任务:

检查源代码中的错误。

优化用于识别缺陷设施的代码。

转录在智能手机上录制的会议以创建会议纪要。

问题在于,在所有这些情况下,员工实际上都获取了三星的专有信息并将其提供给第三方,使其脱离了公司的控制。

当然,一旦发现这些事件发生,三星就警告其员工使用 ChatGPT 的风险。 它的重要工作人员明白,一旦信息被共享,它可能会暴露给未知数量的人。 三星正在采取措施减少未来的此类使用,如果这些措施不起作用,将阻止该工具在其网络上使用。 三星也在开发自己的类似工具供内部使用。

三星事件清楚地表明,企业领导者需要了解公司信息不能以这种方式共享。

我们需要采用 Apple 方法来生成 AI

当然,这就是为什么苹果对 AI 的一般方法如此有意义。 虽然也有例外(包括曾经在 Siri 内部严重共享评分数据),但苹果的策略是尝试开发只需要很少数据即可运行的智能解决方案。 争论的焦点是,如果 Apple 及其系统无法洞察用户的信息,那么该数据仍然是机密、私密和安全的。

这是一个可靠的论点,理所当然地应该扩展到生成人工智能和可能的任何形式的搜索。 Apple 似乎没有与 ChatGPT 相当的产品,尽管它确实有一些构建块,可以在这些构建块上为其硬件创建设备上的技术等价物。 例如,Apple 极其强大的神经引擎似乎拥有运行 LLM 模型的能力,至少在设备上具有某种程度的等效操作。 这样做会提供一个更安全的工具。

尽管 Apple 还没有自己的 Designed In Cupertino 承担 Generative AI 等候,但不可避免的是,随着 ChatGPT 模型的风险得到更广泛的了解,对类似工具的私密和安全访问的需求只会增加。 企业希望在不牺牲机密性的情况下获得生产力和效率。

那么,此类工具的未来似乎很可能基于将此类解决方案尽可能多地从云端转移到设备上。 这肯定是微软似乎正在发出的信号,因为它致力于在 Azure 和其他产品中编织 OpenAI 工具。

与此同时,任何使用 LLM 的人都应该遵循 NCSC 的建议,并确保他们不会在他们提出的查询中包含敏感信息。 他们还应该确保他们不会向公共 LLM 提交“如果公开会导致问题”的查询。

而且,鉴于人是每条安全链的薄弱环节,大多数企业可能需要制定行动计划,以防确实发生侵权行为。 也许 ChatGPT 可以推荐一个?