周二,Nvidia 联合创始人兼首席执行官黄仁勋将 OpenAI 的 ChatGPT 的热议称为人工智能世界的“iPhone 时刻”,并在该公司的春季 GTC 会议上宣布了两款为此类应用提供动力的新芯片。

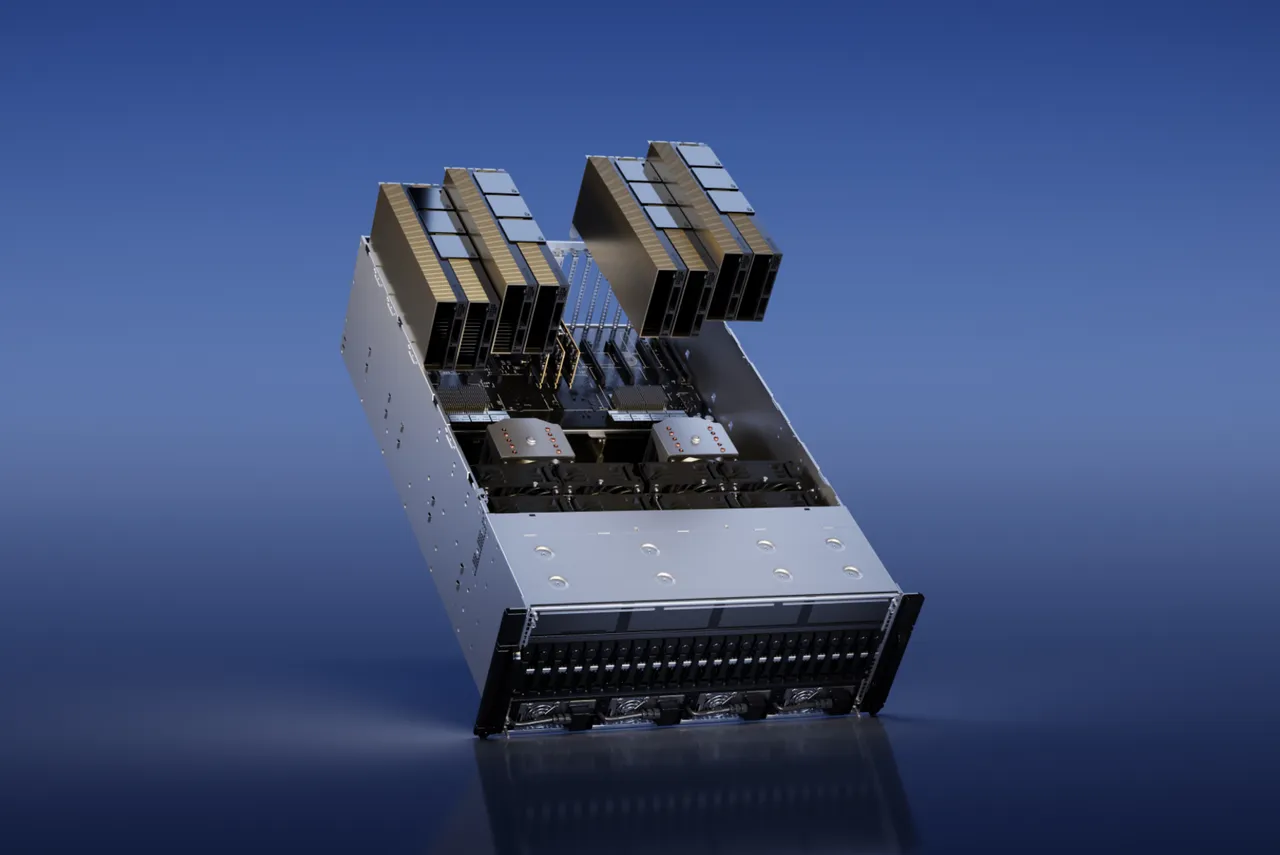

其一,NVIDIA H100 NVL for Large Language Model Deployment,专为处理所谓的大型语言模型上的“推理”任务而量身定制,ChatGPT 就是自然语言程序的一个例子。

另外:最好的 AI 聊天机器人:ChatGPT 和其他值得尝试的有趣替代方案

推理是机器学习程序部署的第二阶段,此时运行经过训练的程序以通过预测来回答问题。

Nvidia 表示,H100 NVL 附带 94 GB 的内存。 该公司表示,与数据中心规模的上一代 A100 相比,其 Transformer Engine 加速“在 GPT-3 上提供高达 12 倍的推理性能”。

Nvidia 的产品在某种程度上可以被视为取代英特尔的游戏,英特尔的服务器 CPU,Xeon 系列,长期以来一直主导着推理任务,而 Nvidia 控制着“训练”领域,这是 ChatGPT 等机器学习程序的阶段。 最先开发。

此外:谷歌向公众开放了其 Bard 候补名单。 这是你如何获得它

Nvidia 表示,H100 NVL 预计将在今年“下半年”上市。

周二发布的第二款芯片是用于 AI Video 的 L4,该公司称其“可以提供比 CPU 高 120 倍的 AI 视频性能,同时能效提高 99%。”

Nvidia 表示,谷歌是第一家提供 L4 视频芯片的云提供商,使用 G2 虚拟机,目前处于私人预览版。 Nvidia 表示,L4 将集成到谷歌的 Vertex AI 模型商店中。

Nvidia 表示,除了谷歌的产品外,L4 还在 30 多家计算机制造商的系统中提供,其中包括研华、华硕、源讯、思科、戴尔科技、富士通、技嘉、惠普企业、联想、QCT 和超微。

在 Huang 的主题演讲中,多次提到了 ChatGPT 的创建者,即初创公司 OpenAI。 Huang 于 2016 年向该公司交付了第一个 Nvidia DGX 系统。Nvidia 表示,OpenAI 将在运行其程序的 Azure 计算机中使用 Hopper GPU。

另:如何使用ChatGPT写代码

本周,作为会议记录的一部分,Huang 与 OpenAI 联合创始人 Ilya Sutskever(ChatGPT 的主要作者之一)进行了“炉边谈话”。

除了新芯片,Huang 还谈到了一个名为 cuLitho 的新软件库,它将部署在芯片制造中。

该计划旨在加快制造光掩模的任务,光掩模是塑造光投射到硅晶片上以制造电路的方式的屏幕。

Nvidia 声称该软件将“使芯片具有比现在更细的晶体管和电线”。 该计划还将加快总设计时间,并“提高能源效率”的设计过程。

Nvidia 表示,500 台运行其 H100 GPU 的 DGX 计算机可以完成 500 个 NVIDIA DGX H100 系统的工作,从而实现 40,000 个 CPU 的工作,“并行运行计算光刻过程的所有部分,有助于减少电力需求和潜在的环境影响 ”

Huang 说,该软件正被集成到全球最大的代工芯片制造商台积电的设计系统中。 它还将被集成到 Synopsys 的设计软件中,Synopsys 是少数几家使用软件工具制造新芯片底板的公司之一。

Synopsys 首席执行官 Aart de Geus 此前曾告诉 ZDNET,人工智能将用于探索人类甚至拒绝考虑的芯片制造设计权衡。

Nvidia 官方博客文章中提供了周二公告的摘要。