炒作表明人工智能 (AI) 已经无处不在,但实际上驱动它的技术仍在发展。 许多 AI 应用程序使用并非专为 AI 设计的芯片——相反,它们依赖于为视频游戏创建的通用 CPU 和 GPU。 这种不匹配导致了一连串的投资——来自 IBM、英特尔和谷歌等科技巨头,以及初创公司和风险投资公司——投入到专为 AI 工作负载设计的新芯片设计中。

随着技术的进步,企业的投资必然会随之而来。 据 Gartner 称,2021 年人工智能芯片收入总额超过 340 亿美元,预计到 2026 年将增长到 860 亿美元。此外,该研究公司表示,2020 年只有不到 3% 的数据中心服务器包含工作负载加速器,而超过 15% % 预计到 2026 年。

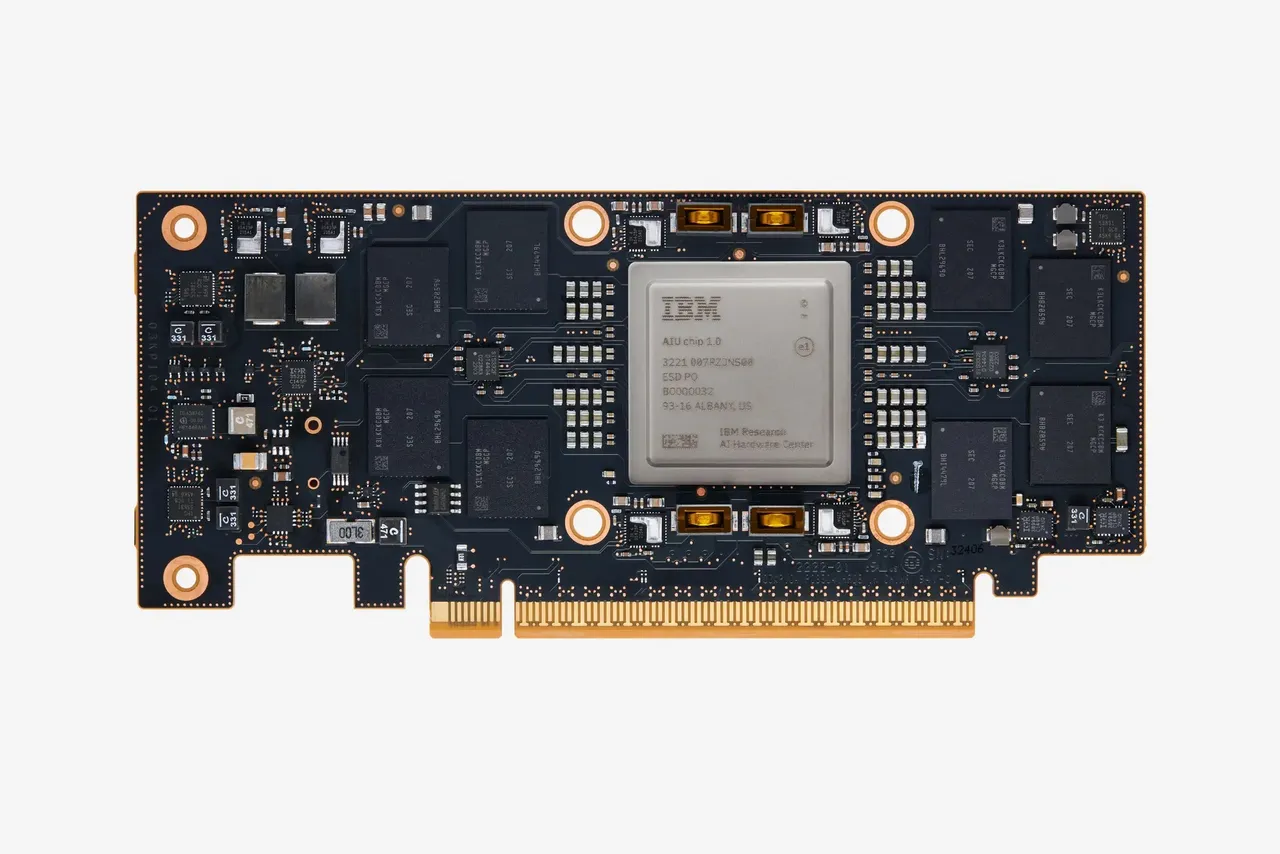

就 IBM 研究院而言,它刚刚推出了人工智能单元 (AIU),这是一种专门用于 AI 的原型芯片。

IBM 表示:“我们的计算能力正在耗尽。人工智能模型呈指数级增长,但用于训练这些庞然大物并在云端服务器或智能手机和传感器等边缘设备上运行它们的硬件并没有像现在这样快速发展。”

另外:人工智能能否帮助解决教育的大数据问题?

AIU 是 IBM Research AI 硬件中心的第一个完整的片上系统 (SoC),专门设计用于运行企业 AI 深度学习模型。

IBM 认为,“传统计算的主力”,也称为 CPU,是在深度学习到来之前设计的。 虽然 CPU 适用于通用应用程序,但它们不太擅长训练和运行需要大规模并行 AI 操作的深度学习模型。

“毫无疑问,在我们看来,人工智能将在很长一段时间内成为 IT 解决方案的基本驱动力,”IBM Research 人工智能计算主管 Jeff Burns 告诉 ZDNET。 “它将以非常广泛和分散的方式融入计算领域,融入这些复杂的企业 IT 基础设施和解决方案。”

Burns 说,对于 IBM 来说,构建有效通用的完整解决方案最有意义,“这样我们就可以将这些功能集成到不同的计算平台中,并支持非常非常广泛的企业 AI 需求。”

AIU 是一种专用集成电路 (ASIC),但可以对其进行编程以运行任何类型的深度学习任务。 该芯片具有 32 个采用 5 纳米技术构建的处理核心,并包含 230 亿个晶体管。 布局比 CPU 更简单,旨在将数据直接从一个计算引擎发送到下一个计算引擎,从而提高能源效率。 它的设计与图形卡一样易于使用,可以插入任何带有 PCIe 插槽的计算机或服务器。

为了节约能源和资源,AIU 利用近似计算,这是 IBM 开发的一种技术,用于以计算精度换取效率。 传统上,计算依赖于 64 位和 32 位浮点运算,以提供一定程度的精度,这对金融、科学计算和其他细节精度很重要的应用程序很有用。 然而,对于绝大多数 AI 应用程序来说,这种精度水平并不是真正必需的。

伯恩斯解释说:“如果你想绘制自动驾驶汽车的轨迹,车道上没有汽车需要的确切位置。” “巷子里有很多地方。”

神经网络从根本上讲是不精确的——它们以一定的概率产生输出。 例如,计算机视觉程序可能会以 98% 的把握告诉您您正在看一张猫的图片。 即便如此,神经网络最初仍然是用高精度算法训练的,消耗了大量的能量和时间。

另外:我测试了一个 AI 艺术生成器,这是我学到的

AIU 的近似计算技术允许它从 32 位浮点运算下降到包含四分之一信息量的位格式。

为确保芯片真正通用,IBM 不仅仅关注硬件创新。 IBM Research 非常重视基础模型,拥有大约 400 到 500 人的团队致力于这些模型。 与为特定任务构建的 AI 模型不同,基础模型是在广泛的未标记数据集上训练的,创建了类似于巨大数据库的资源。 然后,当您需要针对特定任务的模型时,您可以使用相对少量的标记数据重新训练基础模型。

IBM 打算使用这种方法来处理不同的垂直领域和不同的 AI 用例。 公司正在为少数几个领域构建基础模型——这些用例涵盖化学和时间序列数据等领域。 时间序列数据,仅指在固定时间间隔内收集的数据,对于需要观察其设备运行情况的工业公司来说至关重要。 在为少数关键领域构建基础模型后,IBM 可以开发更具体、垂直驱动的产品。 该团队还确保 AIU 的软件与 IBM 拥有的 Red Hat 的软件堆栈完全兼容。