如果你想关注人工智能方面的新闻,你最好随身带一本英语词典,也许还有几本词源词典。

今天的人工智能深度学习形式正在大量使用可能具有严重误导性的普通词汇。 这包括暗示机器实际上正在做人类所做的事情,例如思考、推理、认知、观察、疑惑。

最新的例子是来自伦敦的谷歌人工智能部门 DeepMind 的一个新程序。 DeepMind 研究人员周四公布了他们所谓的 PonderNet,该程序可以选择是探索问题的可能性还是放弃。

DeepMind 将计算机方面的这种练习称为“思考”,但实际上它也可以称为“减少损失”或“停下来着火”,因为它实际上与思考几乎没有关系 该术语的人类意义,更多地与计算机如何完成任务有关。

该程序由科学家 Andrea Banino、Jan Balaguer 和 Charles Blundell 描述,位于神经网络设计和计算机优化的有趣交叉点。

该程序完全是关于计算效率,以及效率和准确性之间的权衡。 正如作者所描述的那样,PonderNet 是“一种新算法,可以根据手头问题的复杂性学习调整计算量。”

如果在某个时间点之前的努力似乎足以让神经网络做出可接受的预测,则 PonderNet 获得了缩短其计算工作量的能力。 相反,如果这样做可以产生更好的结果,它可以扩展其计算。

该程序一方面平衡了深度学习基准测试的准确性目标,另一方面是对进一步努力不会真正产生太大影响的概率猜测。

Banino 及其同事多年来在条件计算等领域的许多研究人员所做的工作。 但他们最直接的影响似乎是他们的谷歌同事亚历克斯格雷夫斯的工作。

格雷夫斯在神经网络设计和计算机操作的交叉领域积累了有趣的调查记录。 例如,他和同事几年前提出了一种“神经图灵机”,其中从寄存器文件中选择内存将是神经网络计算的结果。

就 PonderNet 而言,Banino 和团队正在 Graves 2016 年的工作基础上构建所谓的自适应计算时间。 该论文的见解是,在人类推理领域,问题的陈述和问题的解决方案往往是不对称的。 一个问题有时可能只需要很少的努力就能表达出来,但要花很多时间去弄清楚。 例如,将两个数字相加比将它们相除更容易,尽管符号表示法看起来几乎相同。

根据 Graves 的说法,典型的例子是费马大定理,正如数学家所说,皮埃尔·德·费马 (Pierre de Fermat) 在一本书的页边空白处做的笔记后来花了科学家们三个世纪的时间来证明。

因此,Graves 想出了一种方法,让计算机可以根据问题的复杂性来计算它应该“思考”预测问题的时间。

这实际上意味着应该允许神经网络的多少层来计算预测。 神经网络程序是一台转换机器:它会自动找到将输入转换为输出的方法。 输入必须通过的人工神经元层数才能成功转换为准确的输出,这是衡量计算工作量的一种方法。

那么,思考意味着改变网络层数,从而改变网络的计算,决定计算机应该多快放弃,或者是否应该继续尝试。

正如格雷夫斯所写,

为了提高计算效率和易于学习,动态改变网络在发出输出之前“思考”每个输入的步骤数似乎更可取。 在这种情况下,网络在沿着序列的每一步的有效深度成为迄今为止收到的输入的动态函数。

术语“深度”是指一个程序应该有多少层人工神经元。

格雷夫斯解决这个问题的方法是在神经网络的末端附加一个所谓的“思考成本”,即人们试图最小化的计算时间。 然后程序预测停止计算其预测的最佳计算量。

与开启计算时代的艾伦图灵著名的“停机问题”理论相呼应,Graves 将程序中根据成本计算何时停止的部分标记为“停机单元”。

快进到 PonderNet。 Banino 和团队接手了 Graves 的任务,他们的主要贡献是重新解释了如何思考最后一部分,即停止单元。 Banino 和团队注意到 Graves 的目标过于简单,因为它只是查看最后一个神经网络层并说,“这就足够了”,这并不是一种评估计算成本的非常复杂的方法。

因此,研究人员提出了他们所谓的概率方法。 PonderNet 的开发使用了所谓的马尔可夫决策过程,这是一种状态模型,在网络的每一层处理中,程序都在计算可能性 是时候停止计算了。

这个问题的答案有点平衡:如果神经网络的初始层以前从未成为有效的停止点,则停止的概率为零; 但如果过去的经验表明已经超过了一个阈值,即更多的计算将导致收益递减,则概率可能更接近于一个。

正如作者所定义的那样,“在评估时,网络从停止的伯努利随机变量 […] 中逐步抽样,以决定是继续还是停止。”

证据就在布丁里。 Banino 及其同事将该装置应用于各种神经网络以完成各种任务。 他们写道,这种方法可用于多种机器学习程序,从简单的神经网络馈送到所谓的自注意力程序,如谷歌的 Transformer 及其后代。

在他们的实验中,他们发现程序实际上改变了它的计算量以在测试中做得更好。 他们再次回到格雷夫斯。 那篇论文提出了所谓的奇偶校验。 为程序提供一堆由零、一和负一组成的随机组合的数字,并预测它们的输出是什么。 一个非常简单的神经网络,具有单层人工神经元,基本上会得出五十分准确的答案,就像掷硬币一样。

有了增加计算的能力,Graves 和他的同事构建的程序做得更好。 Banino 和同事发现他们的程序比那个程序做得更好。 特别是,在给定更多随机数字的情况下,PonderNet 继续以高可靠性得出正确的和,而不是 Graves 和团队的程序开始随机猜测。

“PonderNet 能够在这项艰巨的外推任务中实现近乎完美的准确性,而 ACT [自适应计算时间] 仍处于偶然水平,”他们写道。

您可以看到正在进行的关键转变。 Graves 和团队试图强加一个边界,即程序不应超过的有效计算预算量。 Banino 和团队在某种意义上采取了相反的方式,设置了程序可能反复超过的计算级别,因为跨栏运动员越过了每个障碍,在这种情况下是在提高准确性的道路上。

所有这些引人入胜的科学的结果是,它可以为深度学习添加一个重要的工具,即以严格的方式应用条件的能力,以确定程序应该做多少工作才能得出答案。

作者指出了提高神经网络效率的重要性。 鉴于人工智能有加剧气候变化的风险,不断增加的人工智能计算预算被认为是该领域的一个关键伦理问题。 作者写道,“神经网络 […] 需要大量时间、昂贵的硬件和能源来训练和部署。

“PonderNet […] 可用于减少推理时的计算量和能量,这使其特别适合资源有限的平台,例如手机。”

有趣的是,作者还建议 PonderNet 将机器学习朝着“表现得更像算法,而不像‘平面’映射”的方向发展。 他们认为,这种变化可以“帮助开发深度学习方法以充分发挥其潜力”,这是一个相当神秘的断言。

尽管 PonderNet 听起来很有前途,但您不应该被名称误导。 这不是真正的思考。 Merriam Webster 词典将“思考”一词定义为“在头脑中权衡”。 还提供了“反思”和“思考”的定义。

无论人类在做这些事情时发生了什么,它似乎都不涉及要优化的“成本函数”。 人类在思考时也不会权衡成功的可能性,至少不会像程序那样。

当然,有人可能会走进房间,看到你坐在办公桌前陷入沉思,然后有点恼火地问:“你还在想这个吗?” 其他人附加一个成本函数,并计算你在浪费时间的概率。 思考者只是思考。

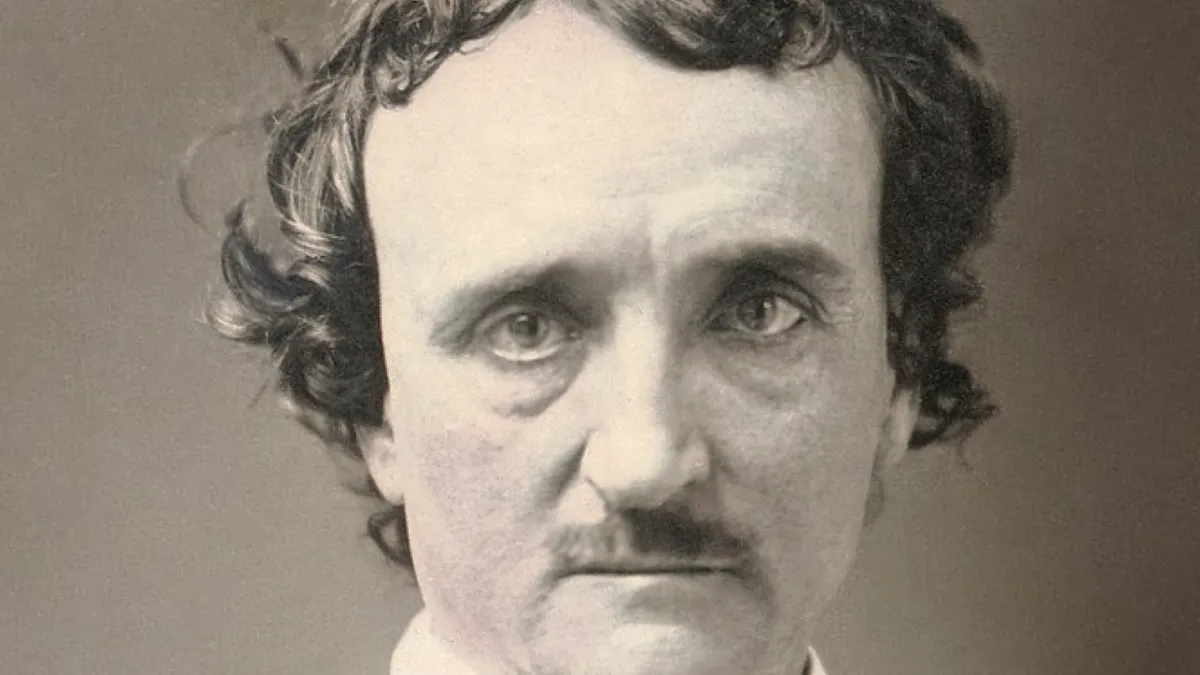

诗人埃德加·爱伦·坡在他的诗歌《乌鸦》的开篇就抓住了沉思行为的一些神秘特质——与其说是过程,不如说是一种体验,一种没有一丝优化痕迹的东西—— 一个沉闷的午夜,而我却在思考,虚弱而疲倦。”