几年前发明了国际象棋冠军神经网络 AlphaZero 的谷歌人工智能部门 DeepMind 在 11 月再次震惊了世界,其程序解决了数十年之久的蛋白质折叠问题。 该计划轻而易举地击败了所有竞争对手,一位研究人员称之为“分水岭时刻”,有望彻底改变生物学。

所谓的 AlphaFold 2 当时仅在 DeepMind 的博客文章和 DeepMind 为他们提交程序的竞赛提供的论文摘要中进行了简短的描述,即蛋白质结构预测技术的关键评估 一年两次的比赛。

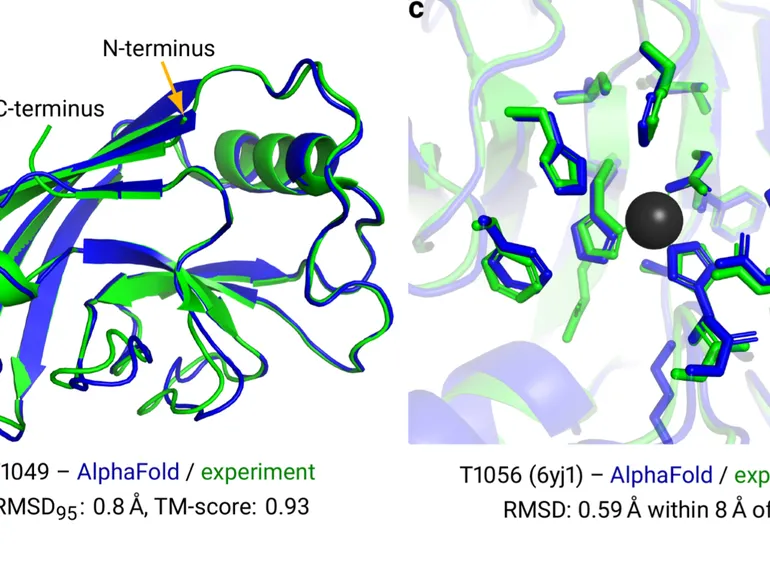

上周,DeepMind 终于透露了它是如何完成的,不仅提供了一篇博文,还提供了一篇由 DeepMind 的 John Jumper 及其同事在《自然》杂志上撰写的 16 页摘要论文、一个 62 页的补充材料集和一个代码库 在 GitHub 上。 Nature 的 Ewan Calloway 关于新细节的一篇报道将数据转储描述为“蛋白质结构走向大众”。

所以我们学了什么? 一些东西。 顾名思义,这个神经网络是第一个 AlphaFold 的继任者,AlphaFold 在 2018 年的前一场比赛中也击败了竞争对手。AlphaFold 2 最直接的启示是,要在人工智能方面取得进步可能需要进行所谓的架构更改。

软件程序的体系结构是所使用的特定操作集以及它们的组合方式。 第一个 AlphaFold 由一个卷积神经网络或“CNN”组成,这是一个经典的神经网络,在过去十年中一直是许多 AI 突破的主力,例如在 ImageNet 计算机视觉竞赛中取得胜利。

但是卷积已经过时了,图在了。或者,更具体地说,图网络与所谓的注意力的结合。

图网络是指可以根据事物的相关性以及它们如何通过友谊(例如社交网络中的人)来评估某些事物的集合。 在这种情况下,AlphaFold 使用有关蛋白质的信息来构建一张图表,显示不同氨基酸之间的距离。

这些图是由注意力机制操纵的,这种机制在 AI 的许多领域中越来越受欢迎。 广义上讲,注意力是对一些输入数据增加额外计算能力的做法。 利用注意力的程序已经在多个领域取得了突破,尤其是自然语言处理,例如谷歌的 Transformer。

在第一个 AlphaFold 中使用卷积的部分在 Alpha Fold 2 中被删除,取而代之的是一整套注意力机制。

注意力的使用贯穿于 AlphaFold 2。AlphaFold 的第一部分是所谓的 EvoFormer,它使用注意力来集中处理计算每个氨基酸与另一个氨基酸的关系图。 由于图形中创建的几何形式,Jumper 及其同事将这种估计图形的操作称为“三角形自注意力”。

与自然语言程序相呼应,EvoFormer 允许三角注意力将信息向后发送到氨基酸序列组,称为“多序列比对”或“MSA”,这是生物信息学中的一个常用术语,其中比较相关的氨基酸序列 一块一块。

由于注意力,作者认为 MSA 和图表处于一种对话中——他们称之为“联合嵌入”。 因此,注意力导致程序各部分之间的通信。

AlphaFold 2 的第二部分,在 EvoFormer 之后,是所谓的结构模块,它应该采用 EvoFormer 构建的图形,并将它们转化为蛋白质 3-D 结构的规格,即赢得比赛的输出 CASP 竞赛。

在这里,作者引入了一种单独计算蛋白质部分的注意力机制,称为“不变点注意力”机制。 他们将其描述为“一种几何感知的注意力操作”。

结构模块在空间中的一种原点处启动粒子,您可以将其视为 3-D 参考场,称为“残余气体”,然后继续旋转和移动粒子以产生最终的 3-D 配置。 同样,重要的是使用注意力机制,粒子相互独立地转换。

为什么图形和注意力取代卷积很重要? 在去年为这项研究提供的原始摘要中,Jumper 及其同事指出,需要超越对所谓“局部”结构的固定。

回到 AlphaFold 1,卷积神经网络的功能是测量氨基酸之间的距离,然后将所有氨基酸对的测量值汇总为二维图片,称为距离直方图或“直方图”。 然后,CNN 会按照 CNN 的方式仔细研究该图片,以找到本地主题,这些主题可以构建成跨越距离范围的越来越广泛的主题。

但是,从局部主题开始的有序进展可以忽略远程依赖性,而远程依赖性是注意力应该捕捉到的重要元素之一。 例如,EvoFormer 中的注意力机制可以将在三角注意力机制中学到的东西与在搜索 MSA 中学到的东西联系起来——不仅仅是 MSA 的一个部分,而是相关氨基酸序列的整个宇宙。

因此,注意力允许实现本质上更“全球化”的飞跃。

我们在 AlphaFold 中看到的另一件事是端到端的目标。 在最初的 AlphaFold 中,物理结构的最终组装只是由卷积驱动,以及他们想出的东西。

在 AlphaFold 2 中,Jumper 及其同事强调了“端到端”地训练神经网络。 像他们说的那样:

“在结构模块和整个网络中,我们通过重复将最终损失应用于输出然后将输出递归地馈送到相同模块来强化迭代优化的概念。使用整个网络的迭代优化(我们称之为“回收” ‘ 并且与计算机视觉中的方法有关)只需很少的额外训练时间就可以显着提高准确性。”

因此,AlphaFold 2 的另一个重要收获是神经网络确实需要不断改进其预测的概念。 这不仅适用于回收业务,也适用于其他方面。 例如,制作氨基酸图表的 EvoFormer 在 EvoFormer 的多个阶段(称为“块”)的每个阶段修改这些图表。 Jumper 和团队将这种不断的更新称为整个网络的“持续通信”。

正如作者指出的那样,通过不断修改,该程序的结构部分似乎“顺利地”改进了其蛋白质模型。 “AlphaFold 对结构不断进行增量改进,直到无法再改进为止,”他们写道。 有时,这个过程是“贪婪的”,也就是说,结构模块在其处理层的早期就找到了一个好的解决方案; 有时,需要更长的时间。

无论如何,在这种情况下,训练神经网络(或网络组合)的好处似乎肯定会成为许多研究人员的重点。

除了这一重大教训之外,AlphaFold 2 的中心还有一个重要的谜团:为什么?

为什么蛋白质以它们的方式折叠? AlphaFold 2 开启了揭示宇宙中每一种蛋白质结构的前景,这又是几十年来取得的成就。 但是 AlphaFold 2 并没有解释为什么蛋白质会呈现出它们现在的形状。

蛋白质是氨基酸,使它们卷曲成给定形状的力相当简单——比如某些氨基酸被正电荷或负电荷吸引或排斥,而一些氨基酸是“疏水的”,意思是,它们会留下来 离水分子更远。

仍然缺乏的是解释为什么某些氨基酸会呈现出如此难以预测的形状。

AlphaFold 2 在构建将序列数据转换为蛋白质模型的机器方面取得了惊人的成就,但我们可能需要等待对该程序本身的进一步研究才能知道它告诉我们有关蛋白质行为的全景图。